Cerebras Systems lanceert de snelste AI-inferentiedienst, die Nvidia H100 met 20 keer overtreft

Brief news summary

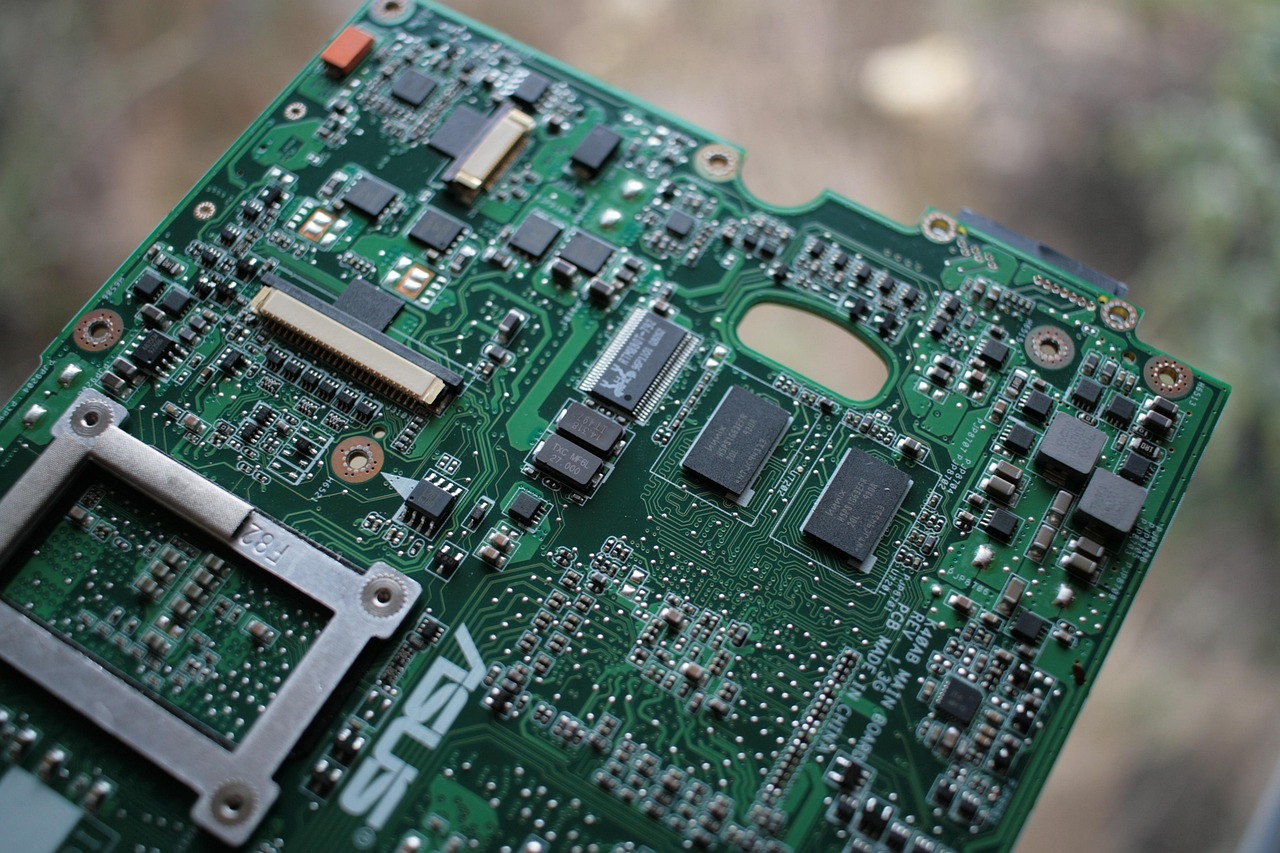

In augustus 2024 lanceerde Cerebras Systems de snelste AI-inferentiedienst ter wereld, met snelheden tot 20 keer sneller dan Nvidia’s H100 GPU. Aangedreven door Cerebras’ wafer-scale engine, integreert het duizenden verwerkingskernen en high-bandwidth geheugen op één enkele silicium wafer, waardoor ongeëvenaarde computationele doorvoer mogelijk is met minimale latentie. Deze technologie ondersteunt grootschalige AI-modellen met honderden miljarden tot trillioenen parameters, om te voldoen aan de eisen in autonome voertuigen, medische diagnostiek, natuurlijke taalverwerking en financiën. Door de beperkingen van traditionele GPU’s te overtreffen, verbetert Cerebras de snelheid van besluitvorming, energie-efficiëntie en verlaagt het operationele kosten. Deze doorbraak markeert een cruciale stap richting gespecialiseerde AI-hardware en bevordert AI-as-a-service modellen die krachtige AI bieden zonder complexe infrastructuur, waardoor nieuwe normen in AI-prestaties worden gezet en de toekomst van AI-innovatie wereldwijd wordt vormgegeven.In augustus 2024 behaalde Cerebras Systems een belangrijke mijlpaal in kunstmatige intelligentie door de lancering van wat zij claimen de snelste AI-inferentie-service ter wereld te zijn. Deze nieuwe service levert prestaties tot twintig keer sneller dan systemen die gebruik maken van Nvidia’s H100 'Hopper' GPU, die jarenlang de standaard was in de industrie voor AI-rekenkracht. Bekend vanwege zijn innovatieve hardware die ontworpen is om AI-werklasten te versnellen, introduceerde Cerebras deze baanbrekende service om te voldoen aan de toenemende vraag naar het inzetten van AI-modellen in diverse sectoren. De service biedt buitengewoon snelle verwerkingssnelheden, waardoor snellere besluitvorming en verbeterde efficiëntie mogelijk worden voor bedrijven en onderzoekers die werken met grootschalige AI-modellen. AI-inferentie—de fase waarin gegevens door getrainde modellen worden verwerkt om voorspellingen te genereren—is cruciaal in toepassingen die realtime reacties vereisen, zoals autonome voertuigen, medische diagnostiek, natuurlijke taalverwerking en aanbevelingssystemen. De verbeterde inferentieprestaties van Cerebras worden verwacht grote impact te hebben in deze gebieden en daarbuiten. Door Nvidia’s bekende H100 GPU tot twintig keer te overtreffen, zet Cerebras nieuwe normen voor snelheid en efficiëntie in AI-berekeningen. Hoewel Nvidia’s H100, gebaseerd op de Hopper-architectuur, veel gebruikt wordt voor AI-training en inferentie, kan deze doorbraak van Cerebras de adoptie van AI-technologie in industrieën versnellen. Deze vooruitgang is gebaseerd op Cerebras’ eigen hardware en systeemarchitectuur. In tegenstelling tot de veelzijdige, geoptimaliseerde GPU’s van Nvidia, maakt Cerebras gebruik van waferscalaandrijvingen die enorme aantallen verwerkingskernen combineren met high-bandwidth geheugen en onderlinge verbindingen op een enkel siliciumwafel. Deze samenhangende structuur levert uitzonderlijke rekenkracht en minimale latentie. De service is ontworpen om te ondersteunen bij het inzetten van steeds grotere AI-modellen—sommigen met honderden miljarden of zelfs biljoenen parameters—die de toenemende rekenvereisten voor inferentie met zich meebrengen. Traditionele GPU’s, hoewel krachtig, ondervinden beperkingen in schaalbaarheid door architecturale beperkingen. Cerebras pakt deze uitdagingen aan door een platform te bieden dat specifiek geoptimaliseerd is voor dergelijke grootschalige modellen, waardoor bedrijven en onderzoekers AI-toepassingen efficiënter kunnen uitvoeren. Dit is cruciaal nu AI zich richt op datagerichte toepassingen zoals complexe natuurlijke taalbegrip, geavanceerde computervisie en simulaties die realtime verwerking van enorme data-input vereisen. De lancering onderstreept een bredere trend in de industrie naar gespecialiseerde hardware die verder gaat dan conventionele GPU-ontwerpen.

Hoewel GPU’s nog steeds essentieel blijven voor AI, drijft de groeiende behoefte aan snellere, energie-efficiëntere en schaalbare rekenkracht innovatie in chipontwerp en systeemintegratie. Cerebras, opgericht om AI-hardware te revolutioneren, belichaamt deze visie met zijn waferscalaandrijving—een van de grootste geïntegreerde circuits ooit gemaakt—die enorme parallelle verwerking en lage latentie binnen zijn architectuur mogelijk maakt. In de praktijk betekent deze ontwikkeling grote implicaties voor sectoren zoals gezondheidszorg, financiën, autonome systemen en cloud computing. Snellere inferentie zorgt voor kortere doorlooptijden voor AI-gestuurde inzichten, verbeterde gebruikerservaringen en mogelijk lagere operationele kosten door een betere energie-efficiëntie en minder hardwarevereisten. Daarnaast kan deze snelheidsstijging innovatiecycli in AI-onderzoek versnellen, waardoor snellere iteraties mogelijk zijn bij het ontwikkelen en inzetten van modellen—van cruciaal belang naarmate AI-modellen steeds meer gespecialiseerd en complex worden. Hoewel gedetailleerde technische benchmarks nog niet openbaar zijn, heeft Cerebras bekendgemaakt dat haar service gebruikmaakt van het dichtmazige netwerk van duizenden verwerkingskernen op haar waferscalaandrijving, verbonden via hogesnelheidspaden. Dit ontwerp zorgt voor aanzienlijk hogere doorvoer en minder dataverplaatsingtov traditionele GPU-systemen. De aankondiging heeft ook geleid tot discussies over concurrentie op de AI-hardwaremarkt. Nvidia heeft lange tijd de markt gedomineerd met haar GPU’s, maar de opkomst van gespecialiseerde AI-versnellers van bedrijven als Cerebras en Graphcore duidt op marktdiversificatie gericht op het optimaliseren van verschillende aspecten van AI-computing. Analisten suggereren dat de doorbraak van Cerebras de bredere adoptie van waferscalaandrijvingen en andere innovatieve architecturen zou kunnen stimuleren, nu de toenemende AI-vraag voortdurende hardware- en systeemprestaties aandrijft. Bovendien ondersteunt de AI-inferentie-service van Cerebras de verschuiving naar AI als een service (AIaaS), waarbij cloudplatforms AI-capaciteiten on-demand aanbieden. Door uitzonderlijke inferentiesnelheden te bieden, positioneert Cerebras zich als een belangrijke spil voor organisaties die krachtige AI nodig hebben zonder te investeren in complexe hardware-infrastructuur. Samengevat markeert de lancering van Cerebras Systems’ AI-inferentie-service een belangrijke sprong in innovatie op het gebied van AI-hardware. Door tot twintig keer sneller te zijn dan gevestigde GPU-technologie, belooft het de efficiëntie van AI-inzet te verbeteren, grotere en complexere modellen mogelijk te maken en de vooruitgang in AI-afhankelijke velden te versnellen. Naarmate het AI-ecosysteem zich ontwikkelt, zullen dit soort hardwaredoorbraken essentieel zijn om nieuwe mogelijkheden te ontsluiten, concurrentievoordelen te bieden aan bedrijven en de toekomst van wereldwijde AI-toepassingen vorm te geven.

Watch video about

Cerebras Systems lanceert de snelste AI-inferentiedienst, die Nvidia H100 met 20 keer overtreft

Try our premium solution and start getting clients — at no cost to you

I'm your Content Creator.

Let’s make a post or video and publish it on any social media — ready?

Hot news

Door AI-gegenereerde deepfake-video's ontstaan ni…

De snelle opkomst van door AI gegenereerde deepfake-video’s vormt een belangrijke wereldwijde uitdaging voor de media-industrie.

De voormalig salesdirecteur van OpenAI gaat de du…

Toen Aliisa Rosenthal in juni 2022 de rol van head of sales bij OpenAI op zich nam, als het eerste commerciële personeelslid van het bedrijf, was het sales team slechts enkele mensen sterk en had het weinig te bieden op commercieel vlak.

Cognizant en NVIDIA werken samen om adoptie van A…

Cognizant Technology Solutions heeft een strategisch partnerschap aangekondigd met NVIDIA om het Neuro AI-platform te implementeren, waarmee een belangrijke stap wordt gezet in het versnellen van de adoptie van AI binnen bedrijven in diverse sectoren.

WordPress AI-team schetst SEO-veranderingen

De verwachtingen in de industrie voor SEO evolueren nu AI-agenten steeds meer gebruik maken van bestaande zoekinfrastructuur, aldus James LePage, co-lead van het WordPress AI-team bij Automattic.

Wat is kunstmatige intelligentie voor sociale med…

Kunstmatige intelligentie (AI) en sociale media vormen een krachtig partnerschap, waarbij AI de productiviteit en prestaties van marketeers op populaire platforms verbetert.

Artisan AI haalt 25 miljoen dollar op om autonome…

Artisan AI, een innovatieve softwarebedrijf gevestigd in San Francisco, heeft $25 miljoen opgehaald in een Series A-investeringsronde, geleid door durfkapitaalbedrijven Y Combinator en HubSpot Ventures.

Washington is verdeeld over AI-chipexports terwij…

Washington blijft opnieuw diep verdeeld over AI.

AI Company

Launch your AI-powered team to automate Marketing, Sales & Growth

and get clients on autopilot — from social media and search engines. No ads needed

Begin getting your first leads today