Kepentingan Token dalam Aplikasi AI dan Pengoptimuman

Brief news summary

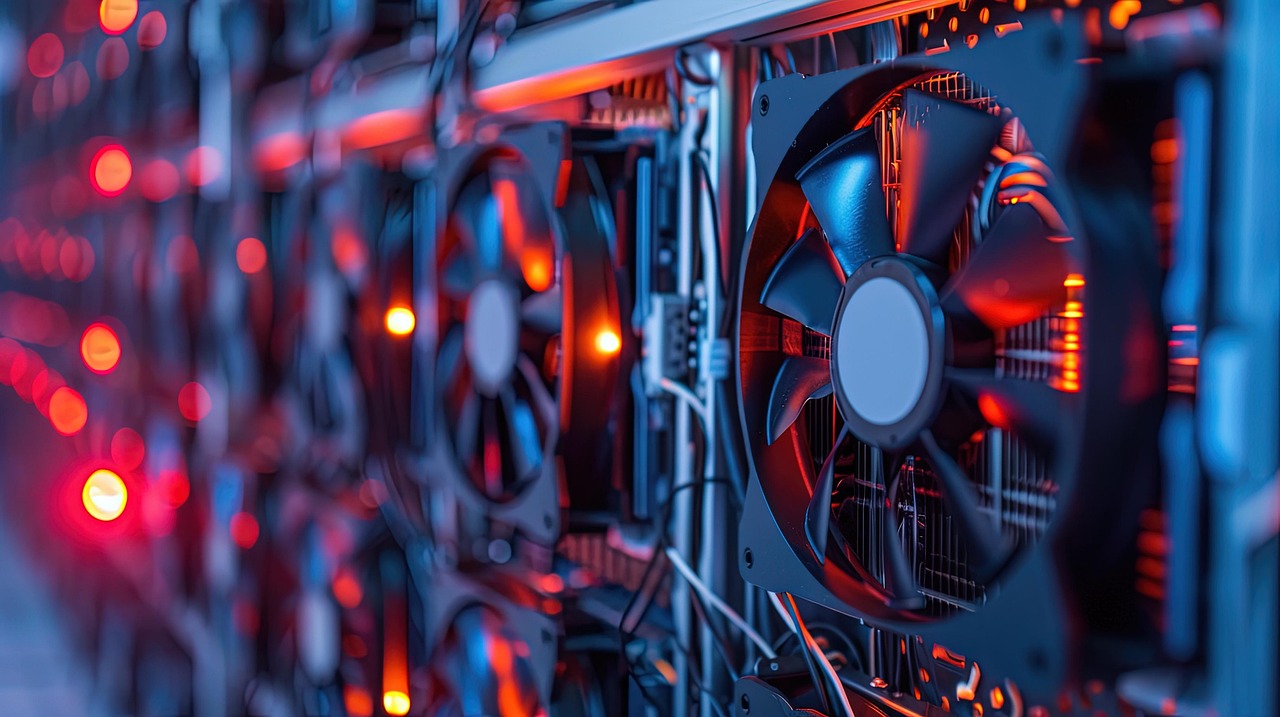

Aplikasi AI memanfaatkan algoritma yang memproses data sebagai token—komponen kecil dari set data yang lebih besar—yang penting untuk meningkatkan prestasi model AI yang bersifat ramalan dan generatif. Kemunculan kilang AI, yang merupakan pusat data khusus, telah meningkatkan kecekapan pemprosesan token dengan ketara, memberi kuasa kepada perniagaan untuk meningkatkan keupayaan AI mereka sambil mengurangkan kos. Satu kajian kes yang ketara menunjukkan bahawa dengan menggunakan GPU NVIDIA dan mengoptimumkan perisian, syarikat-syarikat dapat mengurangkan perbelanjaan pemprosesan token sebanyak dua puluh kali ganda dan melihat peningkatan pendapatan sebanyak dua puluh lima kali ganda dalam hanya empat minggu. Tokenisasi adalah penting kerana ia menukarkan pelbagai jenis data menjadi token yang boleh diurus, memudahkan latihan model AI dan mengurangkan permintaan pengkomputeran untuk prestasi yang lebih baik. Peningkatan dalam token latihan secara signifikan meningkatkan ketepatan ramalan. Setelah latihan, token khusus digunakan untuk memperhalus model, dan semasa inferens, arahan ditukarkan menjadi token untuk menghasilkan respons yang relevan. Dari masa ke masa, pertanyaan yang lebih kompleks memerlukan token tambahan untuk penalaran yang lebih lanjut. Oleh itu, kecekapan ekonomi aplikasi AI bergantung pada pengurusan token yang berkesan, menekankan keperluan untuk pengoptimuman bagi meningkatkan pengalaman dan hasil pengguna, terutamanya melalui infrastruktur yang kukuh dan perisian yang disediakan oleh NVIDIA.Setiap aplikasi AI bergantung kepada algoritma yang memproses data dalam bahasa unik yang terdiri daripada token, iaitu unit kecil yang diambil dari set maklumat yang lebih besar. Token adalah penting untuk model AI, membolehkan mereka mempelajari hubungan dan meningkatkan kemampuan seperti ramalan, penghasilan, dan penaakulan. Kelajuan pemprosesan token memberi kesan langsung kepada kecekapan dan responsif model AI. Kilangan AI— pusat data khusus— direka untuk mempercepatkan proses ini, menukarkan token dari bahasa AI kepada kecerdasan yang boleh dilaksanakan. Infrastruktur ini membolehkan perniagaan memanfaatkan penyelesaian pengkomputeran komprehensif untuk memproses lebih banyak token dengan kos yang lebih rendah, akhirnya meningkatkan nilai pelanggan. Sebagai contoh, pengoptimuman perisian dan penggunaan GPU NVIDIA yang canggih telah mencapai pengurangan 20 kali ganda dalam kos pemprosesan token sambil menjana pendapatan 25 kali ganda dalam beberapa minggu. Tokenisasi adalah proses menukarkan pelbagai jenis data—teks, imej, audio, dan video—kepada token. Tokenisasi yang berkesan mengurangkan kuasa pengkomputeran yang diperlukan untuk latihan dan inferens AI. Pelbagai kaedah tokenisasi boleh meminimumkan saiz perbendaharaan kata, menghasilkan token yang lebih sedikit untuk diuruskan, memudahkan pemprosesan yang lebih pantas. Dalam konteks model bahasa besar (LLM), kata-kata yang lebih pendek boleh diwakili oleh satu token manakala yang lebih panjang boleh dibahagikan kepada beberapa token. Sebagai contoh, "kegelapan" boleh menjadi "gelap" dan "ness, " masing-masing diberikan nilai numerik. Teknik ini membantu model mengenal pasti makna yang dikongsi dan konteks yang berbeza, seperti makna berbeza untuk perkataan "berbohong, " yang boleh bermaksud rehat atau penipuan. Token memainkan peranan penting sepanjang fasa latihan dan inferens AI.

Latihan awal melibatkan tokenisasi set data, seringkali menghasilkan berbilion atau trilion token. Model ini disempurnakan dengan meramalkan token seterusnya, suatu proses yang diulang sehingga mencapai tahap ketepatan yang diinginkan. Pasca-latihan memberi fokus kepada menyesuaikan model dengan tugas atau domain tertentu dengan menyempurnakan mereka dengan token yang relevan. Semasa inferens, model menerima arahan—teks, audio, imej, dll. —menukarkannya kepada token, memprosesnya, dan menjana respons dalam format yang dijangkakan. Tetingkap konteks menentukan berapa banyak token yang boleh diproses sekaligus, mempengaruhi kapasiti model untuk menangani pelbagai input data. Model penaakulan canggih menjana token tambahan untuk merumuskan respons yang lebih tepat terhadap pertanyaan kompleks, memerlukan sumber pengkomputeran yang signifikan. Token juga mempengaruhi ekonomi AI, mewakili pelaburan dalam kecerdasan semasa latihan dan membiayai kos dan pendapatan semasa inferens. Kilangan AI memberi tumpuan kepada inferens berskala tinggi, menjadikan token sebagai wawasan yang dimonetisasi. Model penetapan harga mungkin mengenakan bayaran berdasarkan bilangan token yang digunakan, membenarkan penggunaan yang fleksibel, seperti menjana output panjang dari input token yang minimum. Pengalaman pengguna dibentuk oleh metrik yang berkaitan dengan token seperti masa untuk token pertama dan latensi antara token, yang mempengaruhi responsif dan kualiti aplikasi AI. Menyeimbangkan faktor-faktor ini adalah penting untuk mengoptimumkan interaksi pengguna. Untuk chatbot, masa respons yang cepat meningkatkan penglibatan, manakala aplikasi lain memprioritikan penghasilan output berkualiti tinggi. Platform AI NVIDIA menyediakan alat dan infrastruktur komprehensif untuk membantu organisasi mengoptimumkan penggunaan token mereka, membolehkan mereka memaksimumkan nilai yang diperoleh daripada aplikasi AI dan mendorong sempadan kecerdasan di pelbagai sektor.

Watch video about

Kepentingan Token dalam Aplikasi AI dan Pengoptimuman

Try our premium solution and start getting clients — at no cost to you

I'm your Content Creator.

Let’s make a post or video and publish it on any social media — ready?

Hot news

Cara Menilai Ketelusan AI dalam Alat Pemasaran: F…

Rebekah Carter Kenaikan pesat AI dalam pemasaran adalah luar biasa—dari ujian awal penjana kandungan hinggalah AI kini membentuk keseluruhan bajet iklan, saluran kandungan, dan segmen pelanggan

Analisis Replify: Jualan AI dan Perkhidmatan Pela…

Data teragregat daripada pengendali kecergasan menunjukkan bahawa jualan dan perkhidmatan pelanggan berkuasa AI secara signifikan mengurangkan masa tindak balas, memulihkan pendapatan, dan menjimatkan ribuan jam pekerja setiap bulan.

Pasaran Pelayan AI China Dijangka Meningkatkan Pe…

Menurut kajian terbaru TrendForce, peningkatan permintaan untuk pelayan kecerdasan buatan (AI) mendorong empat penyedia perkhidmatan awan utama di Amerika Utara (CSPs) untuk mempercepatkan pembangunan dalaman cip bersepadu khusus aplikasi (ASIC).

Perjanjian Nvidia dan Groq menggoncangkan Silicon…

Windsurf, sebuah syarikat pengekodan AI, hampir diperkosakan oleh OpenAI dengan nilai $3 bilion, tetapi urusan tersebut runtuh di saat-saat terakhir.

AI dalam Permainan Video: Mencipta Persekitaran y…

Dalam beberapa tahun kebelakangan ini, kecerdasan buatan (AI) telah merevolusikan industri permainan, mengubah kedua-dua pembangunan permainan dan pengalaman pemain di seluruh dunia.

AI dalam SEO: Meningkatkan Penciptaan dan Pengopt…

Kecerdasan Buatan (AI) sedang dengan pantas membentuk semula bidang penciptaan dan pengoptimuman kandungan, khususnya dalam bidang pengoptimuman enjin carian (SEO).

TrendForce: Pelayan AI Tingkatkan Penghantaran GP…

Menurut kajian terkini oleh TrendForce, pasaran pelayan secara keseluruhan baru-baru ini mencapai tahap penstabilan, menunjukkan tempoh perkembangan dan penyesuaian yang stabil dalam industri.

AI Company

Launch your AI-powered team to automate Marketing, Sales & Growth

and get clients on autopilot — from social media and search engines. No ads needed

Begin getting your first leads today