Meta prévoit d'automatiser jusqu'à 90 % des évaluations des risques, suscitant des préoccupations concernant la vie privée et la sécurité

Pendant des années, les équipes de vérification de Meta ont évalué les risques potentiels à chaque lancement de nouvelles fonctionnalités sur Instagram, WhatsApp et Facebook, en examinant des préoccupations telles que la menace sur la vie privée des utilisateurs, les dangers pour les mineurs ou la diffusion de contenus trompeurs ou toxiques. Ces évaluations de la confidentialité et de l'intégrité étaient principalement menées par des évaluateurs humains. Cependant, des documents internes obtenus par NPR révèlent que Meta prévoit d’automatiser jusqu’à 90 % de ces évaluations de risques prochainement. Cela signifie que les mises à jour critiques des algorithmes, les nouvelles fonctionnalités de sécurité et les modifications dans le partage de contenus seront principalement approuvées par des systèmes d’IA sans l’examen habituel du personnel, qui prend en compte les répercussions imprévues ou les abus. Au sein de Meta, ce changement est perçu comme avantageux pour les développeurs de produits, car il accélère la sortie des mises à jour et des fonctionnalités. Pourtant, des employés actuels et anciens craignent que cette automatisation ne conduise à une mauvaise évaluation des risques, risquant ainsi de causer des dommages dans le monde réel. Un ancien dirigeant de Meta a exprimé sa préoccupation que des lancements plus rapides avec moins de rigueur dans l’évaluation augmentent la probabilité de résultats négatifs, car moins de problèmes seraient détectés en amont. Meta a déclaré avoir investi des milliards pour protéger la vie privée des utilisateurs et que ces nouvelles modifications dans l’évaluation des risques visent à simplifier le processus de décision tout en conservant l’expertise humaine pour les questions nouvelles ou complexes. Elle affirme que seules les décisions « à faible risque » seront automatisées. Cependant, des documents internes suggèrent que l’automatisation pourrait s’étendre à des domaines sensibles comme la sécurité de l’IA, le risque pour la jeunesse et l’intégrité globale de la plateforme, couvrant le contenu violent et la désinformation. Le nouveau processus consiste à faire remplir aux équipes produits un questionnaire pour obtenir une « décision instantanée » de l’IA, qui détaille les risques et les mesures d’atténuation nécessaires. Auparavant, les évaluateurs de risques devaient approuver les mises à jour des produits avant leur déploiement ; désormais, les ingénieurs s’auto-évaluent en grande majorité, sauf s’ils demandent spécifiquement une revue humaine. Ce changement confère davantage de pouvoir aux ingénieurs et aux équipes produits—qui ne sont souvent pas spécialisées en confidentialité—pour prendre des décisions, ce qui soulève des inquiétudes concernant la qualité des évaluations.

Zvika Krieger, ancien directeur de l’innovation responsable chez Meta, a averti que les équipes produits sont principalement jugées sur leur rapidité à lancer des nouveautés, pas sur la sécurité, et que l’auto-évaluation risque de devenir une formalité qui omet de repérer des problèmes importants. Il a reconnu qu’il y avait un potentiel pour l’automatisation, mais a mis en garde contre une dépendance excessive à l’IA, pouvant détériorer la qualité des revues. Meta a minimisé ces craintes, en précisant qu’elle audite les décisions d’IA pour les projets sans revue humaine. Ses opérations en Europe, régies par des réglementations strictes comme la Digital Services Act, continueront à bénéficier d’une supervision humaine depuis son siège en Irlande. Certaines de ces modifications coïncident avec la fin du programme de vérification des faits de Meta et un assouplissement de ses politiques contre le discours haineux, ce qui indique un changement plus large de l’entreprise vers des mises à jour plus rapides et moins de restrictions de contenu—un affaiblissement des garde-fous de longue date destinés à empêcher les abus sur la plateforme. Cette stratégie s’inscrit dans la continuité des efforts du PDG Mark Zuckerberg pour s’aligner avec des figures politiques comme l’ancien président Trump, dont l’élection Zuckerberg a qualifiée de « tournant culturel ». La recherche d’automatisation s’inscrit aussi dans la stratégie de longue date de Meta visant à utiliser l’IA pour accélérer ses opérations face à la concurrence de TikTok, OpenAI et autres. Meta a récemment renforcé son recours à l’IA pour faire respecter la modération des contenus, utilisant des modèles linguistiques qui surpassent parfois l’humain dans certains domaines réglementaires. Cela permet aux évaluateurs humains de se concentrer sur des cas plus complexes. Katie Harbath, ancienne experte en politique publique chez Facebook, soutient l’utilisation de l’IA pour améliorer la vitesse et l’efficacité, mais insiste sur la nécessité de contrôles humains. À l’inverse, un autre ancien employé de Meta questionne la sagesse d’accélérer les évaluations de risques, soulignant que l’analyse approfondie des nouveaux produits révèle souvent des problèmes ignorés. Michel Protti, directeur de la confidentialité des produits chez Meta, a décrit ces changements comme une manière de responsabiliser les équipes produits et de faire évoluer la gestion des risques pour simplifier la prise de décision. La mise en place de l’automatisation a été accélérée durant avril et mai 2024. Cependant, certains initiés critiquent cette vision, insistant sur le fait que l’ôter la dimension humaine de l’évaluation des risques compromet l’important regard humain sur les dangers potentiels, qualifiant cette démarche d’« irresponsable » au regard de la mission de Meta. En résumé, Meta passe d’une évaluation des risques menée par des humains à une majorité d’évaluations pilotées par l’IA en vue d’accélérer l’innovation, tout en soulevant de graves préoccupations internes quant à la rigueur de l’analyse, aux dangers possibles et à la capacité de l’IA à traiter des enjeux éthiques et sécuritaires complexes.

Brief news summary

Meta passe d'une évaluation des risques menée par des humains à une évaluation principalement automatisée par l'IA pour les mises à jour d'Instagram, WhatsApp et Facebook, automatisant jusqu'à 90 % des examens de confidentialité et d'intégrité. Cela vise à accélérer le lancement des produits en permettant aux développeurs d'autoévaluer les risques avec moins de supervision humaine. Meta affirme que l'automatisation gère principalement les cas à faible risque, tandis que des experts traitent les problématiques complexes. Cependant, des critiques, y compris d'anciens employés, préviennent que ce changement pourrait négliger des dommages graves tels que les violations de la vie privée, la sécurité des jeunes et la désinformation. Ce changement s'aligne avec la fin du programme de vérification des faits de Meta et un assouplissement des contrôles de contenu, reflétant la volonté du PDG Mark Zuckerberg de privilégier un développement rapide face à la concurrence de TikTok et OpenAI. Bien que l'IA améliore l'efficacité, les experts insistent sur le rôle essentiel du jugement humain pour prévenir des dommages incontrôlés. Meta cite des audits en cours et la réglementation de l'UE comme garanties, mais des insiders craignent qu'une réduction de la surveillance humaine ne cause des conséquences néfastes et sous-estime les impacts réels dans le monde.

AI-powered Lead Generation in Social Media

and Search Engines

Let AI take control and automatically generate leads for you!

I'm your Content Manager, ready to handle your first test assignment

Learn how AI can help your business.

Let’s talk!

La blockchain dans l'éducation : sécuriser les di…

Les institutions éducatives du monde entier adoptent de plus en plus la technologie blockchain pour sécuriser et vérifier les diplômes, dans le but de lutter contre la fraude aux diplômes et de renforcer la confiance dans les registres académiques.

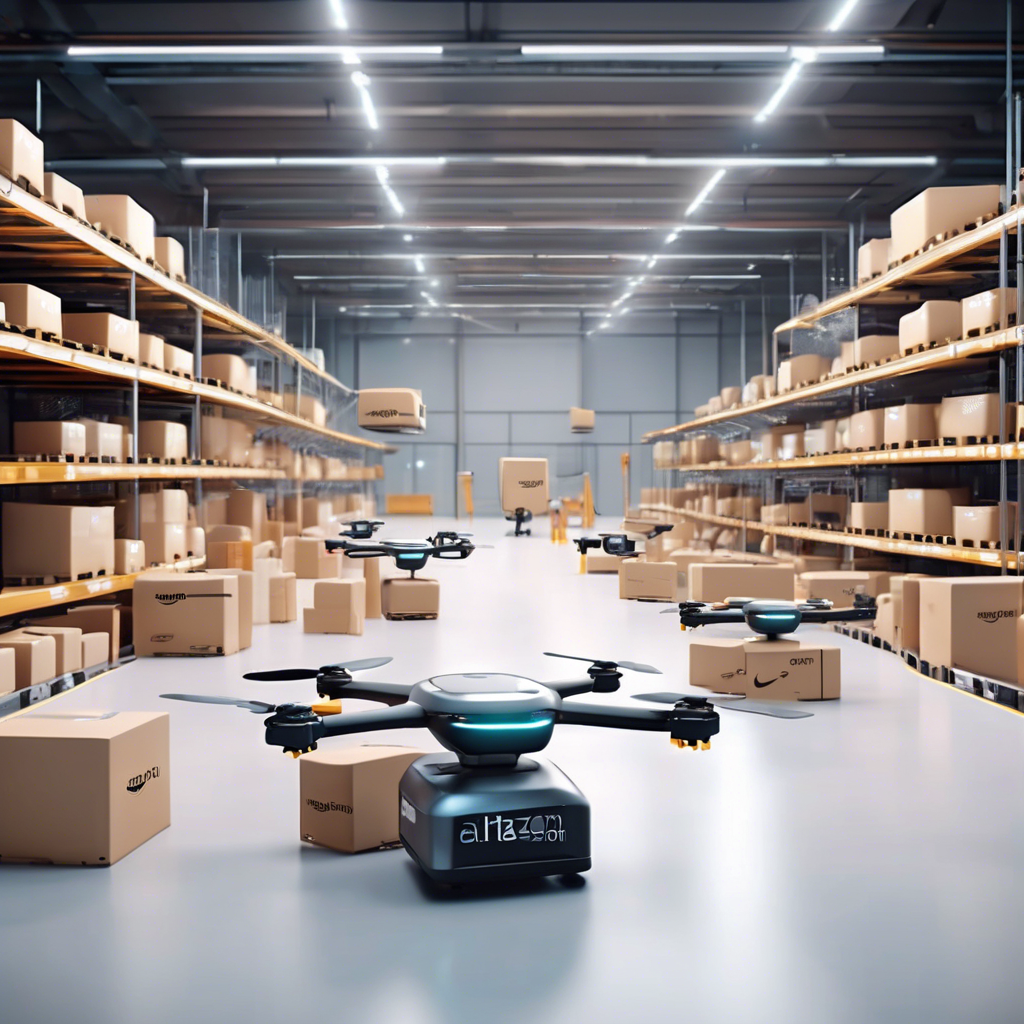

La livraison et la logistique d'Amazon bénéficien…

Amazon a annoncé une importante expansion de l’utilisation de l’intelligence artificielle pour améliorer la livraison et la logistique, marquant une avancée significative dans l’intégration de technologies de pointe au sein de sa chaîne d’approvisionnement.

La Malaisie active l'infrastructure nationale de …

Malaisie a franchi une étape majeure dans sa transformation numérique avec le lancement officiel de l’Infrastructure Blockchain de Malaisie (MBI), une plateforme nationale sécurisée et évolutive permettant de développer et déployer des applications blockchain dans des secteurs clés tels que la finance, la santé et la logistique.

L'adoption de l'IA pourrait augmenter le PIB mond…

Une étude récente menée par le réseau mondial de services professionnels PricewaterhouseCoopers (PwC) a révélé que l’adoption des technologies d’intelligence artificielle (IA) pourrait avoir un impact économique profond.

Citi prévoit que le marché des stablecoins passer…

Citi, une institution financière mondiale de premier plan, a publié une prévision projetant une croissance importante du marché des stablecoins au cours de la prochaine décennie.

Lightmatter dévoile une puce photonique révolutio…

Lightmatter, une startup de la Silicon Valley, a lancé une puce photonique de pointe conçue pour accélérer les calculs d'intelligence artificielle (IA) sans augmenter la consommation d'énergie, améliorant ainsi l'efficacité énergétique.

Le PDG de Bybit évoque le piratage de 1,5 milliar…

Lors d'une récente interview dans le podcast Wu Blockchain, Ben Zhou, PDG de Bybit, a détaillé une importante faille de sécurité qui s'est produite le 22 février 2025, lors d’un transfert entre les portefeuilles froids et chauds de la plateforme, entre 9h30 et 10h00 UTC.

Auto-Filling SEO Website as a Gift

Auto-Filling SEO Website as a Gift

Auto-Filling SEO Website as a Gift

Auto-Filling SEO Website as a Gift